Brugen af datakilder - når du skal bruge fakta

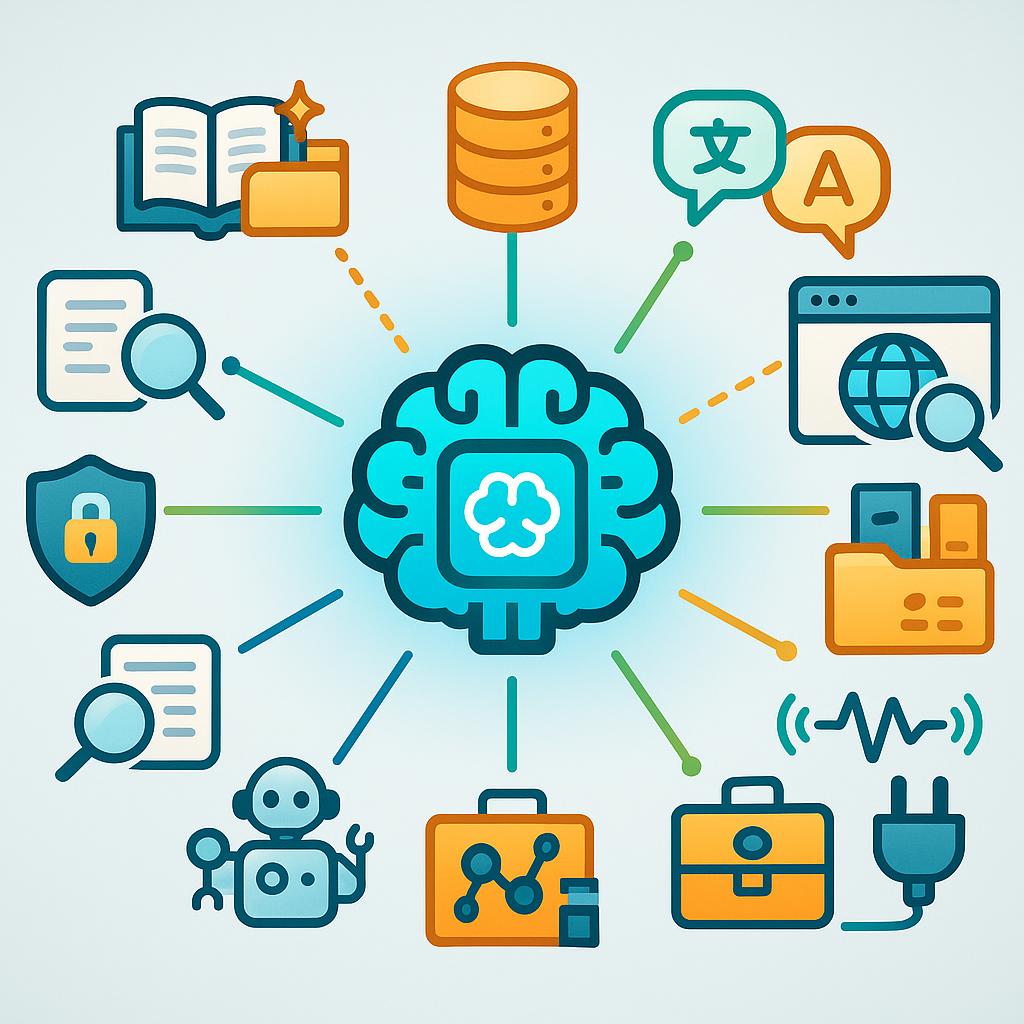

Brugen af datakilder må ikke være et tilfældigt add-on til en chat: professionel anvendelse af LLM’er kræver, at selve LLM-logikken får styringen over, hvilke data der hentes, og hvordan de anvendes i et sammenhængende behandlingsflow. Mange beslutningstagere har set imponerende demos, hvor ét spørgsmål giver ét perfekt svar, men i praksis opstår den reelle forretningsværdi først, når LLM træder ind som et integreret beslutnings- og analyseled i eksisterende processer.

Brugen af datakilder må ikke være et tilfældigt add-on til en chat: professionel anvendelse af LLM’er kræver, at selve LLM-logikken får styringen over, hvilke data der hentes, og hvordan de anvendes i et sammenhængende behandlingsflow. Mange beslutningstagere har set imponerende demos, hvor ét spørgsmål giver ét perfekt svar, men i praksis opstår den reelle forretningsværdi først, når LLM træder ind som et integreret beslutnings- og analyseled i eksisterende processer.

Når AI/LLM skal flyttes fra pilot til drift, fra PoC til værdiskabende elemet, fra Teknologi til arbejdskraft, så skal der ændres fokus. Vi skal gå fra isolatede modeltests og “størst mulig model” til effekt i forretningsprocesser, sporbarhed og sikkerhed i opnåelsen af de bedste resultater.

Et centralt designprincip er modularitet: i stedet for én monolitisk promptarkitektur bør systemet opdeles i specialiserede assistenter med klart ansvar. Eksempler på roller er problemformulerer, fakta-henter (vektor- eller DB-adgang), validerer, og summarizer. Hver assistent skal have definerede kontrakter for input/ output, samt klare kvalitetskriterier og fejlmekanismer.

Kvaliteten af svar afhænger langt mere af hvordan information struktureres og præsenteres for modellen end af blot at vælge en større model. Prompt-design, kontekstvinduer, chunking og relevante metadata påvirker, hvordan modellen anvender information. En gennemtænkt struktur, som matcher modellens træningspræferencer og vidensrepræsentation, giver ofte bedre resultater end at øge modelstørrelsen.

Indbyg validerings- og provenance-lag i arkitekturen. Assistenter bør inkludere automatiske checks, versionsstyring af kilder og human-in-the-loop-godkendelse, så hvert svar kan spores tilbage til kilder og beslutningsregler. Det reducerer risikoen for fejltolkninger og øger tilliden i organisationen.

Dokumentbaseret viden via RAG og vektor-stores

Vektor-stores er en central metode til at gøre dokumenter og afgørelser søgbare for LLM’er. Rå dokumenter skal forberedes: chunkes i relevante enheder, konverteres til embeddings og beriges med metadata (dato, kilde, kontekst). Denne forberedelse sikrer, at søgningen finder det rette faktum i den rigtige kontekst.

Det er ikke nok at have “gode data” — data skal være struktureret, så de harmonierer med modellens måde at repræsentere viden på. Modeller udvikler under træning præferencer for bestemte strukturer; overser man dette, kan selv korrekte datasæt føre til utilfredsstillende eller misvisende svar. Derfor er datadesign lige så vigtigt som datamængde.

Relationelle databaser som autoritativ kilde til fakta og tal

Relationelle databaser som autoritativ kilde til fakta og tal

Relationelle databaser udgør ofte autoritative kilder til transaktionelle facts og tal. Forretningsspørgsmål kræver præcis SQL-eksekvering og korrekt fortolkning af resultater. Derfor anvendes specialbyggede assistenter, der oversætter business-intent til SQL, eksekverer under kontrollerede forhold og validerer, at de hentede data rent faktisk besvarer det oprindelige spørgsmål.

Disse databaseassistenter bør inkludere fejlhåndtering, provable mapping (dokumentation af hvordan kolonner/filtre relaterer til spørgsmålet) og konsistenskontroller. Kombinationen af vektor-retrieval og SQL-opslag kan orkestreres i et hybridflow med fallback-regler, cache og regler for løsning af modstridende information.

Opdateret ekstern viden via søgning på åbent web

Åbent web er en tredje vigtig kilde ved behov for opdateret, offentlig information. Moderne søgeassistenter kan iterativt formulere og raffinere forespørgsler, filtrere støj og rangere hits efter relevans. Kvaliteten af resultatet afhænger i høj grad af assistentens evne til at omsætte et informationsbehov til præcise søgequeries.

Samtidig må juridiske og etiske hensyn adresseres: håndtering af ophavsret og terms of service er nødvendigt, og man skal skelne mellem informationssøgning til problemløsning og dataindsamling til modeltræning. Praktiske anvendelser inkluderer artikelskrivning med kildehenvisning, markeds- og nyhedsovervågning og kvalitetssikring af indkomne oplysninger.

Modellens indbyggede viden via ekspertassistenter

Modellernes indbyggede viden er en ofte undervurderet ressource. Ved at designe ekspertassistenter kan man hurtigt trække på modellerne til problemstrukturering, hypotesegenerering og identifikation af videnshuller uden at integrere eksterne kilder. Det er en lav-omkostningsvej til hurtig afprøvning, men kræver efterfølgende validering, da modellen kan være forældet eller hallucinere facts.

En god praksis er at lade ekspertassistenter fungere som første lag: de strukturerer opgaven, identificerer hvilke facts der mangler, og beslutter — baseret på orkestreringsregler såsom confidence thresholds og human-in-the-loop — om der skal hentes data fra vektor-stores, databaser eller web.

Samlet set anbefales en iterativ implementering: start med indbyggede ekspertassistenter til problemformulering og beslutningsstruktur, tilføj vektor-stores for dokumentbaserede facts, integrer relationelle databaser for præcise tal og afslut med raffinerede søgeassistenter når modenheden og behovet kræver det. Implementér samtidig dokumentation, versionsstyring og auditspor som ikke-funktionelle krav.

Samlet set anbefales en iterativ implementering: start med indbyggede ekspertassistenter til problemformulering og beslutningsstruktur, tilføj vektor-stores for dokumentbaserede facts, integrer relationelle databaser for præcise tal og afslut med raffinerede søgeassistenter når modenheden og behovet kræver det. Implementér samtidig dokumentation, versionsstyring og auditspor som ikke-funktionelle krav.

Vejen til succes med AI/LLM handler ikke om at finde den “rigtige model”, men om at designe den rigtige helhed: modularitet, velstruktureret data, valideringslag og klare orkestreringsregler forvandler teknologien fra et isoleret eksperiment til et operationelt forretningsværktøj med målbar værdi.